阿里云重大突破:Aegaeon获SOSP收录,破解GPU浪费困局

10/20/2025,,2025年10月18日,在韩国首尔举办的第31届操作系统原理研讨会(SOSP)上,阿里云发布的“Aegaeon”计算池化解决方案研究成果成功入选。

该方案创新性地解决了AI模型服务中普遍存在的GPU资源浪费问题,在阿里云模型市场测试中,实现了英伟达GPU用量大幅削减82%的显著成效。

SOSP(操作系统原理研讨会)由ACM SIGOPS主办,是计算机系统领域顶级学术会议,平均每年收录的论文数量仅有数十篇, 被誉为计算机操作系统界的“奥斯卡”,本届SOSP大会仅收录66篇论文。

阿里Aegaeon 系统

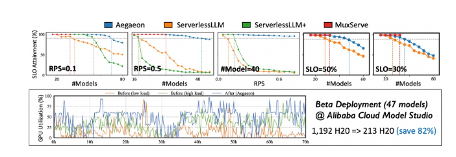

云服务商当前在提供 AI 模型服务时,面临着严重的资源效率低下问题。平台需要同时托管数千个 AI 模型以处理海量并发 API 调用,但用户请求往往高度集中在少数几个热门模型上,例如阿里巴巴的 Qwen 系列模型。研究人员发现,这种“长尾效应”导致了严重的资源闲置:在阿里云的模型市场中,竟有 17.7% 的 GPU 算力仅被用于处理 1.35% 的请求,造成了巨大的成本浪费。为解决这一痛点,Aegaeon 系统应运而生。它通过创新的 GPU 资源池化技术,允许单个 GPU 动态服务于多个不同的 AI 模型,打破了以往 GPU 与特定模型绑定的低效模式。

在阿里云模型市场进行的为期超过三个月的 Beta 测试中,Aegaeon 系统展现了卓越的效能。测试数据显示,服务数十个参数量高达 720 亿的大模型,所需的英伟达 H20 GPU 数量从 1192 个成功减少至 213 个,数量削减高达 82%。

这项由北京大学与阿里云合作的研究成果,被认为是“首个揭示并解决市场上并发大语言模型服务存在过高成本”的公开工作,为行业提供了全新的优化思路。

值得一提的是,阿里云首席技术官周靖人也是该论文的作者之一。周靖人是国际电气与电子工程师协会会士(IEEE Fellow),国际计算机协会会士(ACM Fellow),阿里巴巴集团副总裁,阿里云智能 CTO、达摩院副院长。

如何从底层系统软件层面优化,以更好地支撑和赋能上层AI应用,已成为全球学术界和工业界关注的焦点。未来AI的发展将不仅依赖于硬件算力的单纯增长,更需要通过系统级的软件创新来深度挖掘现有硬件的潜力。

该方案创新性地解决了AI模型服务中普遍存在的GPU资源浪费问题,在阿里云模型市场测试中,实现了英伟达GPU用量大幅削减82%的显著成效。

SOSP(操作系统原理研讨会)由ACM SIGOPS主办,是计算机系统领域顶级学术会议,平均每年收录的论文数量仅有数十篇, 被誉为计算机操作系统界的“奥斯卡”,本届SOSP大会仅收录66篇论文。

阿里Aegaeon 系统

云服务商当前在提供 AI 模型服务时,面临着严重的资源效率低下问题。平台需要同时托管数千个 AI 模型以处理海量并发 API 调用,但用户请求往往高度集中在少数几个热门模型上,例如阿里巴巴的 Qwen 系列模型。研究人员发现,这种“长尾效应”导致了严重的资源闲置:在阿里云的模型市场中,竟有 17.7% 的 GPU 算力仅被用于处理 1.35% 的请求,造成了巨大的成本浪费。为解决这一痛点,Aegaeon 系统应运而生。它通过创新的 GPU 资源池化技术,允许单个 GPU 动态服务于多个不同的 AI 模型,打破了以往 GPU 与特定模型绑定的低效模式。

在阿里云模型市场进行的为期超过三个月的 Beta 测试中,Aegaeon 系统展现了卓越的效能。测试数据显示,服务数十个参数量高达 720 亿的大模型,所需的英伟达 H20 GPU 数量从 1192 个成功减少至 213 个,数量削减高达 82%。

这项由北京大学与阿里云合作的研究成果,被认为是“首个揭示并解决市场上并发大语言模型服务存在过高成本”的公开工作,为行业提供了全新的优化思路。

值得一提的是,阿里云首席技术官周靖人也是该论文的作者之一。周靖人是国际电气与电子工程师协会会士(IEEE Fellow),国际计算机协会会士(ACM Fellow),阿里巴巴集团副总裁,阿里云智能 CTO、达摩院副院长。

如何从底层系统软件层面优化,以更好地支撑和赋能上层AI应用,已成为全球学术界和工业界关注的焦点。未来AI的发展将不仅依赖于硬件算力的单纯增长,更需要通过系统级的软件创新来深度挖掘现有硬件的潜力。

声明:如有信息侵犯了您的权益,请告知,本站将立刻删除。